中國通用大模型領(lǐng)域如今已跑出了六家獨角獸公司——其中只有一家,搜不到任何公開估值,甚至沒有融資新聞,就已經(jīng)被市場默認列入“獨角獸”隊伍。這家公司就是階躍星辰。

喧囂沸騰的“百模大戰(zhàn)”中,階躍星辰以近乎沉寂的狀態(tài)低調(diào)了一年,直到今年3月才浮出水面。

其發(fā)布的Step系列大模型是一套完整的“組合拳”:Step-1千億參數(shù)語言大模型、Step-1V千億參數(shù)多模態(tài)大模型,以及Step-2萬億參數(shù)MoE(混合專家架構(gòu))語言大模型預(yù)覽版。

Step-1V一經(jīng)發(fā)布便登上了OpenCompass多模態(tài)大模型3月榜榜首,二三名分別是阿里的QWen-VL-Max以及谷歌的GeminiProVision,OpenAI的GPT-4V位列第四。

Step-2預(yù)覽版則是國內(nèi)大模型初創(chuàng)公司首次公開萬億參數(shù)MoE語言大模型。理論上而言,這是逼近GPT-4發(fā)布初始水平的關(guān)鍵節(jié)點。

不多言不多語,但一登臺就炸場的姿態(tài),大概足以形容階躍星辰的行事風(fēng)格。

在幕后掌控這家公司行為調(diào)性的人是姜大昕。2023年創(chuàng)業(yè)之前,姜大昕是微軟全球副總裁、微軟亞洲互聯(lián)網(wǎng)工程研究院(STCA)的首席科學(xué)家,主導(dǎo)過微軟搜索引擎Bing,以及智能語音助手Cortana、微軟云Azure、辦公全家桶Microsoft 365等一系列微軟當(dāng)家產(chǎn)品的自然語言理解系統(tǒng)。

深厚的技術(shù)背景使其習(xí)慣于嚴謹和客觀地表達。談及技術(shù)細節(jié),他會給出明確的判斷:“如果大語言模型要上萬億參數(shù),MoE架構(gòu)幾乎是必然選擇。”

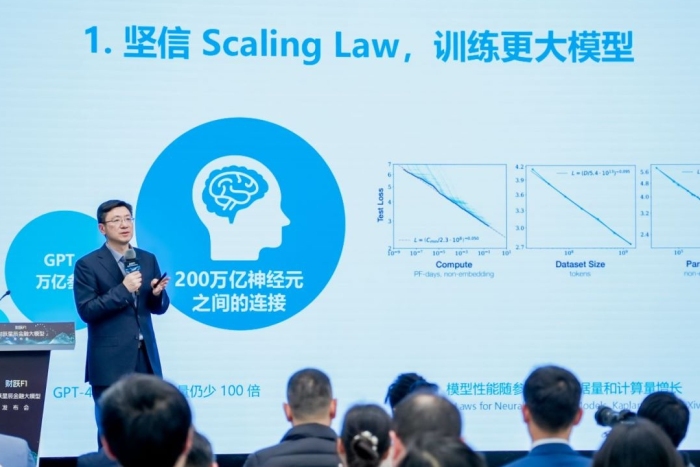

他信仰Scaling Law(規(guī)模法則),認為在肉眼可見的未來,至少還有十萬億和百萬億兩個數(shù)量級,但并不排除腦神經(jīng)科學(xué)領(lǐng)域有朝一日能夠在Scaling Law和多模態(tài)之外找到通往AGI(通用人工智能)的可能。

一些公司合作方會用“實在”來形容他。這種描述矛盾而統(tǒng)一,因為他既會揚言“我們的多模理解國內(nèi)第一”,也會承認“還在追趕去年發(fā)布的GPT-4”。背后所依托的邏輯是他所掌握和相信的技術(shù)現(xiàn)實。

在微軟16年,姜大昕說自己形成最堅不可摧的認知是開放心態(tài)和“growth mindset”(成長型思維)——這是老東家微軟的文化之一,也是他決定創(chuàng)業(yè)的心境來源。

他判斷“上一代搜索已經(jīng)做到頭了”。從“Boosting Tree”(提升樹)到神經(jīng)網(wǎng)絡(luò)興起,從CNN(卷積神經(jīng)網(wǎng)絡(luò))、RNN(循環(huán)神經(jīng)網(wǎng)絡(luò))、LSTM(長短期記憶網(wǎng)絡(luò))再到BERT(谷歌團隊提出的一種自然語言處理預(yù)訓(xùn)練技術(shù)),姜大昕曾把每一代技術(shù)都用進搜索,使其實現(xiàn)從“馬車”到“汽車”的轉(zhuǎn)變。

直到2022年ChatGPT橫空出世,他意識到,這是從“地上跑”到“天上飛”的質(zhì)變。

因此,如果你不知道對這家新出現(xiàn)的公司具體期待什么,不妨期待它會如何定義下一代搜索,畢竟它擁有傳統(tǒng)搜索引擎時代最有話語權(quán)的團隊之一。

階躍星辰會如何用大模型來定義下一代搜索?又如何追上與GPT-4的差距?姜大昕給出了自己的答案。

以下為姜大昕采訪實錄(界面新聞略作編輯):

界面新聞:你們算是國內(nèi)第一個公布萬億參數(shù)MoE大模型的公司,之前一直保持低調(diào),現(xiàn)在希望在行業(yè)里樹立一個什么樣的認知?

姜大昕:去年國內(nèi)開始提“百模大戰(zhàn)”,但很多公司是針對行業(yè)或者應(yīng)用場景發(fā)布了大模型,真正從頭開始做通用大模型的滿打滿算十幾二十家,相當(dāng)于已經(jīng)做完第一輪分化。

我們認為通用大模型還會走得更遠,往后發(fā)展有兩個維度:一個是Scaling Law,從千億到萬億參數(shù),甚至到百萬億;另外光做語言模型是不夠的,要想達到所謂的通用人工智能,就要做多模態(tài)理解和生成的融合,首先要做一個多模態(tài)理解的模型。

沿著這兩條路,公司發(fā)布了萬億參數(shù)語言大模型的預(yù)覽版Step-2,以及多模態(tài)大模型Step-1V。這代表了我們在GPT-3.5之后兩個很重要的觀點,一個是模型要大,二是多模態(tài)理解和生成的統(tǒng)一是通往AGI的必經(jīng)之路。

界面新聞:單從模型的角度,怎么理解你們與GPT-4之間的差距?比如Minimax剛剛發(fā)了abab 6.5,也是萬億參數(shù)MoE大模型,他們會展示各種開源測試集的結(jié)果比對。

姜大昕:這是個很有意思的問題。前段時間在迪拜的世界政府峰會上,OpenAI首席執(zhí)行官Sam Altman有一個觀點很出圈,我覺得很對。

他說GPT-5對比GPT-4,是各個維度都強了一圈。這句話字面意思是“我的通用能力變強了”,但反過來講還有一個意思是,“我朝著某一個維度方向去打磨也可以很強”。通過犧牲一些維度去增強另一個維度,這個維度可以強過GPT-4。就好像一個大學(xué)生和一個學(xué)習(xí)了焊工、鉗工的初中生相比,后者可以在某個維度上超過大學(xué)生。所以刷榜并不是特別科學(xué),因為題都是公開的。

有些說法甚至非常有誤導(dǎo)性。比如說“全方位能力達到了GPT-4的90%”,聽著很牛,但假設(shè)GPT-4在某個能力上是90分,你做到90%就是81分,看上去好像也不錯。但反過來想,GPT-4的錯誤率是10,你的錯誤率是19,幾乎是人家的兩倍,在應(yīng)用的時候體感肯定是不一樣的,用戶只會覺得你做對是應(yīng)該的,但會記住你的錯誤比別人多了近一倍。

界面新聞:和GPT-4的通用能力對比,你們對Step-2下的結(jié)論是什么?

姜大昕:GPT-4是動態(tài)的,我們現(xiàn)在的模型也還在最后的打磨階段,希望到今年上半年整個打磨完成以后,能夠?qū)?biāo)去年GPT-4剛出來的水平。

界面新聞:現(xiàn)在國內(nèi)的通用大模型是不是還在集體追趕GPT-4剛剛發(fā)布的狀態(tài)?

姜大昕:對。這是一個相對務(wù)實的目標(biāo),我們不會動不動就說我們超過GPT-4,沒有這個必要去吸引眼球。因為你可以有各種辦法在一些小維度上超過它,甚至分分鐘就可以超過,但這有什么意義?

界面新聞:Step-2采用的MoE架構(gòu),現(xiàn)在也很受關(guān)注。這種架構(gòu)響應(yīng)速度、推理效率都更快更高,但也存在訓(xùn)練穩(wěn)定性、通信成本等問題。階躍是什么時候決定以及為什么決定采用這個架構(gòu)?怎么去克服這個架構(gòu)本身可能存在的一些問題?

姜大昕:想把模型參數(shù)擴大到萬億的話,MoE幾乎是一個必選項。就像做科研或者做工程,很多決策就是各個維度之間的最佳平衡,MoE也是在性能、參數(shù)量、訓(xùn)練成本、推理成本這些維度權(quán)衡下的最佳選擇。

至于說它要解決的很多挑戰(zhàn),我覺得這就是OpenAI的核心技術(shù),我們要想繼續(xù)往上攀登的話,這個問題遲早要解決。

我們自建機房是一個巨大的優(yōu)勢,因為可以有所有硬件的細節(jié)。我們是系統(tǒng)組、算法組從硬件開始就做一個聯(lián)合的優(yōu)化。

界面新聞:商業(yè)模式上,你們是toB(企業(yè))和toC(消費者)一起做嗎?

姜大昕:不算,我們主力還是在toC。toB的話,我們不是一單一單接的典型打法,是只選擇一些大行業(yè)。比如說和上海報業(yè)旗下的界面財聯(lián)社成立一個合資公司,由這家公司去承接生意,我們提供算法和模型。

界面新聞:如何看待C端產(chǎn)品的商業(yè)前景?很多人認為C端極易打價格戰(zhàn),那它能成立的、有健康現(xiàn)金流的商業(yè)形態(tài)會是什么樣?

姜大昕:這一輪雖然技術(shù)上發(fā)生了很大的變革,但我覺得技術(shù)不是護城河,技術(shù)只能給你一個窗口期。在這個窗口期內(nèi),你一定要構(gòu)建公司產(chǎn)品的護城河。

我覺得沒有什么新鮮的,商業(yè)模式基于人的需求,而需求這么多年不會變。現(xiàn)在只是說技術(shù)變了,找到產(chǎn)品能夠賣出的商業(yè)模式就完了。

界面新聞:有人說你們算是國內(nèi)最后一家大模型公司,你怎么看?會不會覺得入局比較晚?

姜大昕:我覺得不晚,而且我也不認為我們一定是最后一家,可能哪一天又冒出來一家。

界面新聞:當(dāng)初為什么選擇在上海注冊公司?

姜大昕:上海對人工智能有一個總體生態(tài)上的布局,從芯片到通用大模型,再到各行各業(yè)的應(yīng)用,規(guī)劃得非常清楚。上海的環(huán)境也很適合創(chuàng)業(yè),比如徐匯、濱江,有非常多的創(chuàng)業(yè)公司。

界面新聞:在微軟的16年,讓你積淀下來最堅不可摧的認知和能力是什么?

姜大昕:開放的心態(tài),還有就是微軟有個“growth mindset”(成長型思維模式)。意思是不要被過去的一些認知所局限,空杯心態(tài)、仰望星空。

過去的知識也許可以幫你判斷一件事情的價值,但也要多聽取別人的意見,選擇性吸收,最終是讓自己不要活在過去。你要永遠知道,年輕人比你更牛,這個事情在我們公司是非常非常正確的,年輕人也是最厲害的。

界面新聞:在大模型領(lǐng)域創(chuàng)業(yè)的人,有楊植麟這樣帶著“天才少年”標(biāo)簽的,有王小川這種有成功創(chuàng)業(yè)經(jīng)驗的,也有你這樣在科技巨頭統(tǒng)領(lǐng)重要業(yè)務(wù)線的人,你覺得這個行業(yè)這一代領(lǐng)軍人物之間,最終拼的是什么?

姜大昕:個人有個人的特點,我覺得這對企業(yè)是個好處。每個企業(yè)會有自己獨特的文化價值觀,還有組織基因,有各自成功的路徑。

界面新聞:這種價值觀或者組織基因,可能會讓公司在什么事情上變得特別不同或者有優(yōu)勢?

姜大昕: 它會影響到方方面面,這個東西講起來很虛,但又很實在,因為會決定做事的方式。

比如一些企業(yè)合作方聽完我們的介紹以后,會用“實在”來形容我們。我就問,您說這話是一個褒義詞還是個貶義詞(笑)。對方的意思是,他走訪了很多公司,基本上每家都會或多或少說比GPT-4做得好,只有到了我們這里,我說我們在追趕GPT-4,承認跟GPT-4之間還有差距。

界面新聞:階躍現(xiàn)在有大概150人,團隊規(guī)模的增長曲線是怎樣的?

姜大昕:我們一開始招人比較快,把訓(xùn)練初始版本模型的人給招起來了。中間有一段時間相對來說比較慢,產(chǎn)品還是在小步往前探索階段,那段時間并沒有進很多人。產(chǎn)品剛跑起來的時候,可能就10個人。后來到了下半年,我們才開始擴招產(chǎn)品和工程體系的同學(xué),然后才有冒泡。

界面新聞:行業(yè)里像百川智能、Minimax等,大概都是兩三百人的體量,你怎么理解大模型公司人才密度的問題?

姜大昕:這個領(lǐng)域說人才密度這件事我是認可的。這里面涉及兩件事,一個是平均人才密度,還有一個就是,一家公司里最頂尖的那幾個人決定了大模型的高度,100個人未必干得過那10個人,所以系統(tǒng)、數(shù)據(jù)、算法這三個維度我們都要有最頂級的人才。

最近我非常高興的事情是算法團隊又壯大了一些。因為從GPT-3.5到GPT-4,一方面你要有算法能力,另外就是系統(tǒng)要跟上,但如果要探索我說的那條路徑,從單模態(tài)到多模態(tài),需要很多不同領(lǐng)域的算法人才。

我現(xiàn)在在各個方向都找到了頂尖的人才,這也是我“浮出”之后的好處。

界面新聞:每一個加入的人你都會自己親自面試嗎?

姜大昕:對于這些leader我會的,而且都不是面試,真的是聊天、吃飯,有的還聊了好幾次,吃了好幾次。

界面新聞:感覺你在融資信息的發(fā)布上挺謹慎的,但其他家都宣傳得很熱鬧。為什么階躍不怎么去提融資的事情?

姜大昕:我覺得沒有必要。我們最終的目標(biāo)是把模型訓(xùn)出來,那我們知道自己的融資節(jié)奏和方式就好。

界面新聞:但如果有高融資或者高估值,應(yīng)該也更容易在市場上建立頭部印象?

姜大昕:現(xiàn)在的好處是,人工智能領(lǐng)域確實有一批投資人是非常懂的,他們知道這是一個長期且比較耗錢的項目,也愿意相信我們的技術(shù)實力。

界面新聞:你所信仰的AGI可以怎樣概括?

姜大昕:AGI目前確實沒有一個準(zhǔn)確的定義,我也不想給它一個(定義),只能非常概括地說,達到人的智能就叫AGI 。而且我覺得這里面最重要的一個字就是“G”(general),通用。

界面新聞:你給公司規(guī)劃了“單模態(tài)-多模態(tài)-多模理解和生成的統(tǒng)一-世界模型-AGI”的路徑,每個階段要走多長時間是可估算的嗎?

姜大昕:不好預(yù)測。就像我看到ChatGPT之前,都還會說自然語言處理這件事,常識和推理需要十年二十年來解決,結(jié)果一夜之間就解決了。所以有的科學(xué)突破可能在積累上早就發(fā)生了,但有點像大家說的“涌現(xiàn)”,只看到“砰”地一下上去了,是一種跳變。但這個朝著目標(biāo)邁進的過程,只要沒有達到那個點,它就是0。

界面新聞:階躍對于明年有什么具體的目標(biāo)?

姜大昕:朝著GPT-4.5/5去努力,一個是規(guī)模擴大到10萬億參數(shù),第二個是從能力上,我希望明年對多模理解和生成的統(tǒng)一有突破,能夠同時理解和生成。

整條線我們都看得很清楚了,包括我們處在什么階段、什么是確定性的,接下來肯定是在現(xiàn)有的確定性基礎(chǔ)上再往前走。

界面新聞:達到萬億參數(shù)模型之后,推進Scaling Law最難的事情是什么?

姜大昕:最難的不是一件,是四件事情,就是我們說的算力、系統(tǒng)、數(shù)據(jù)、算法。

界面新聞:感覺你是一個非常堅信Scaling Law的人,這個定律有到頭的時候嗎?

姜大昕:這是個很好的問題。在肉眼可見的未來,我覺得至少還有兩個數(shù)量級。我們到年中應(yīng)該才算真正攀上去萬億,那么10萬億是個確定性事件,一定會攀。

界面新聞:10萬億對應(yīng)的是GPT-5?

姜大昕:不知道是GPT-4.5還是GPT-5,就看OpenAI下一個模型出來的是個什么。其實 GPT-4是2022年10月份就訓(xùn)完了,去年4月份發(fā)布是因為它后來打磨又用了6個月時間,跟我們現(xiàn)在狀態(tài)差不多。

雖然OpenAI年初發(fā)布了Sora,但最新一代大模型到底叫GPT-4.5還是GPT-5,多大參數(shù)規(guī)模,都不知道。我們基于它的能力、路線,包括它用的卡做一個推測的話,至少是個10萬億級別。

界面新聞:那第二個數(shù)量級就要到百萬億。

姜大昕:這里有一個參考,就是人腦的神經(jīng)元連接是200萬億,但我覺得不是一個特別有效的參考,因為人和機器現(xiàn)在沒有任何可直接對比的關(guān)系,可能只是給人一個目標(biāo)。

界面新聞:除了這個路徑之外,還存在別的可能彎道超車的技術(shù)路線嗎?

姜大昕: 除了剛才的兩條路線,還有第三條路徑是解讀人腦到底是怎么工作的,即腦神經(jīng)科學(xué)。

現(xiàn)在所謂大腦神經(jīng)網(wǎng)絡(luò)和真正的神經(jīng)網(wǎng)絡(luò)之間,我覺得是一種很牽強附會的類比——把它的構(gòu)造想象成神經(jīng)元、樹突、軸突這些東西,但人腦可能完全不是這么工作的。

但最近有一些有趣的發(fā)現(xiàn),冥冥之中好像人腦的一些規(guī)律在我們最新的大模型設(shè)計當(dāng)中得到了體現(xiàn)。比如人的智能來自大腦皮層,是一個簡單結(jié)構(gòu)的不斷重復(fù),正好對應(yīng)了Transformer架構(gòu)的某種特征。還有就是,它認為人的智能來自對世界的建模,叫作 reference framework,這個和我們現(xiàn)在把大量知識輸入、壓縮、對世界建模從而產(chǎn)生智能的工作,好像從邏輯上也對應(yīng)了。

但從生理上看,人的神經(jīng)元產(chǎn)生生物放電、化學(xué)遞質(zhì)這個過程到底是什么樣的?我們現(xiàn)在訓(xùn)練一個初中生水平的智能,就要消耗這么多能源,人的大腦就兩三斤,消耗能量也就這么一點,它是怎么做到的?這里面還蘊藏很多大自然的奧秘,實際上是可以幫你反哺。

你要么就是學(xué)習(xí)它,要么從它那里得到靈感去改進大模型,甚至說不定在某個時刻,機器人聰明到一定程度,會去看明白之后告訴你,或者默默地就把自己給修改了,那我就覺得很恐怖了(笑)。

界面新聞:你之前提到過“上一代搜索到頭了”。那你對這個時代的搜索有什么初步定義嗎?或者說它未來可能的形態(tài)是什么樣,會取代誰?

姜大昕:是個很好的問題,我覺得它是分階段不斷往前演進的。

首先,它會讓用戶的搜索體驗更好。上一代搜索引擎逼用戶養(yǎng)成了一個習(xí)慣,就是只能拿關(guān)鍵字提問,因為假如問一個自然語言,用戶篤定搜索引擎不懂。但是大模型出現(xiàn)以后,不僅可以讓這件事自然語言化,還可以多輪(對話)。

大模型會先幫你把前幾十個文檔和網(wǎng)頁全看了,然后總結(jié)一套信息給你,還能提供出處,從結(jié)果呈現(xiàn)上也比原來好很多,從單純的信息檢索變成了知識獲取。所以(大模型時代的)搜索第一個階段是,解決了用戶提問的困難和看答案的效率。

搜索本身其實不是一個端到端的任務(wù),大多人搜索是為了完成一個工作或者任務(wù)。所以搜索將來怎么能夠把外部搜索、本地搜索,還有工作環(huán)境的知識整合在一起,嵌入到一個端對端的工作流里面,我覺得可能是未來搜索的一個方向。

界面新聞:如果不考慮Google自己會進化這件事,現(xiàn)在的通用大模型其實都是要取代曾經(jīng)的Google?

姜大昕:在取代這件事情上,我覺得推演起來非常有意思。

很多人在思考,大模型出來以后,搜索引擎公司會產(chǎn)生一個什么樣的變化?包括我們躍問在內(nèi)的很多AI產(chǎn)品都是個聚合搜索,它是在現(xiàn)有搜索引擎的基礎(chǔ)上,把Top 10或者Top 20的結(jié)果做了一個網(wǎng)頁整合。

所以我覺得Google等搜索引擎公司會長期存在。就你從一個Query(疑問)進來,到我從1萬億個網(wǎng)頁當(dāng)中,把Top 20的結(jié)果反饋給你,這件事情永遠要存在。

至于是哪家公司我不知道,但這件事情不會消失,因為大模型沒有能力在很短的時間內(nèi)把1萬億網(wǎng)頁全部看一遍,它只能做到把你給我的20個網(wǎng)頁看一遍。

從商業(yè)模式來說,對于搜索引擎公司就非常tricky(棘手)——這種情況我是跟還是不跟?跟了,可能會損失廣告收入,要不跟就得看著用戶往別人那走。

所以它的一個解決方法可能是,在跟的同時秀廣告,它有一段路要去探索這種商業(yè)模式是不是成立:你付費了我可以不給你廣告,你不付費,對不起,你就得看廣告。

界面新聞:前段時間行業(yè)里關(guān)于研發(fā)、應(yīng)用、商業(yè)化等爭議非常多,你看了這么多觀點之后,有覺得和你的想法比較貼切的嗎?

姜大昕:其實每個人都沒有錯,站在他們的角度,只是各自說了一個不同的事情,然后人為捏在一起之后,好像觀點是很對立的,其實我覺得并不矛盾。

界面新聞:作為創(chuàng)業(yè)者,研發(fā)和應(yīng)用之間你有什么傾向?

姜大昕:我們一直說模型和應(yīng)用要同一個公司做。

界面新聞:所以你覺得雙輪驅(qū)動是成立的?

姜大昕:對。我們公司從第一天開始,就確定模型和應(yīng)用都要做,因為模型需要應(yīng)用作為牽引和數(shù)據(jù)的補充。當(dāng)你具體到某個應(yīng)用的時候一定要通用模型跟它深度綁定,應(yīng)用才能做到極致。

反過來也是一樣,我不覺得一個光做應(yīng)用的公司,沒有一個模型跟它深度綁定的話,它能做到極致。

界面新聞:但這對創(chuàng)業(yè)公司會是一個巨大的消耗,也非常考驗后期,比如創(chuàng)業(yè)者的融資能力。

姜大昕:同意,因為這一輪大模型創(chuàng)業(yè),大家會跟芯片做類比,上來就是明牌重注這樣的格局,沒辦法。

界面新聞:對全球大模型行業(yè)的第一梯隊和第二梯隊有什么樣的預(yù)測?

姜大昕:第一梯隊現(xiàn)在就是OpenAI的GPT,Anthropic的Claude,還有Google的Gemini,每一家背后都是一朵云。

經(jīng)過一年的角逐以后,除非OpenAI馬上放一個GPT-4.5/5把大家再震暈了,否則以他們當(dāng)家的三款模型來說,水平差不了太多,至少GPT-4和Claude 3是,從Gemini Pro來看是接近了。

第二梯隊我覺得就兩家,x.AI的Grok和Meta的Llama,這兩家確實錢多、卡多、人才多,但它們慢了,只能隨時準(zhǔn)備開源掀桌子。

我判斷開源追不上閉源,除非閉源在走的時候出現(xiàn)了重大挫折,比如GPT-4.5/5發(fā)不出來,但我覺得是個小概率事件。閉源還是會一直往前走,而且勢頭不會太慢,至少走到10萬億甚至到百萬億,都會以這樣的速度持續(xù)下去。

界面新聞:對標(biāo)全球的第一第二梯隊,國內(nèi)大模型的整體水平在哪里?

姜大昕:第二梯隊。國內(nèi)進步很快,但是距離GPT-4,Claude 3還是有一定差距。除了模型本身還有認知上的差距。OpenAI是積累了很久。

界面新聞:明年國內(nèi)大模型大概會達到一個什么樣的水平?

姜大昕:取決于兩個因素,一個是它們(第一梯隊)有多快,現(xiàn)在最大的變量就是OpenAI新的模型到底是個什么樣子,這會影響明年的格局。另一個要看國內(nèi)有幾家能在年底前達到GPT-4。

轉(zhuǎn)載來源:界面新聞 作者:伍洋宇

京公網(wǎng)安備 11010802028547號

京公網(wǎng)安備 11010802028547號